2分で読める生成AIのいま Vol.29「続:データセキュリティから見る生成AIのタイプ」-医療における生成AIガイドラインから-

ひとくちに「生成AI」と言っても

チャット型AI、API、企業提供サービス、オンプレAI などタイプはさまざま。

そしてタイプによって データの扱い方・安全性は大きく違います。

前回は「データセキュリティから見る生成AIのタイプ」を整理し、

結論として、生成AIのセキュリティレベルは

オンプレAI > 企業提供AIサービス > クラウドAPI > 個別API > チャット型AI

の順に堅牢、とお伝えしました。

今回は、特に医療分野において対応するガイドラインを確認し、AIに関するセキュリティ管理について理解を深めたいと思います。難しい内容ですが、先に要点を解説していますので、ご安心ください!

前回に引き続き、医療田さん(病院医師)、機械屋さん(エンジニア)の会話でどうぞ。

======

機械屋:

今回は、前回の内容を踏まえて、「生成AIのセキュリティに関連するガイドラインの記載」について確認したいと思います。

状況は医療施設に絞って検討しますが、高いセキュリティレベルの情報を扱う上では、ほかの分野でも参考になると思います。

医療田:

お願いします!

● 関連する4つのガイドライン

機械屋:

今回扱うのは以下の4つです:

1. 厚生労働省の「医療情報システム安全管理ガイドライン(第6版)」についてのQ&A

2. 医療・ヘルスケア分野における生成AI利用ガイドライン(第2版)

3. ヘルスケア領域において生成AIを活用したサービスを提供する事業者が参照するための自主ガイドライン (ヘルスケア生成AI活用ガイド) 第2.0版

4. AI事業者ガイドライン(第1.1版)

その中でも、特に1と2のガイドラインが重要ですね。

医療田:

。。うっく

機械屋:

、、?

大丈夫ですか?医療田さん。

医療田:

うん、や、

えっと、

ガイドライン4つ、か。。最後まで耐えられるかな、私。

機械屋:

ははは。。

では先に、この4つのガイドラインの「最大公約数」、つまり

"この4つのガイドラインが共通して要求している水準はどこか?"

をお示ししますね。

医療田:

おお、、それはありがたい。

● ガイドライン4つの共通項から「どのAIが使えるのか?」を総括

機械屋:

先に要点をいうと、これらのガイドラインで共通しているのは以下のようになっています。

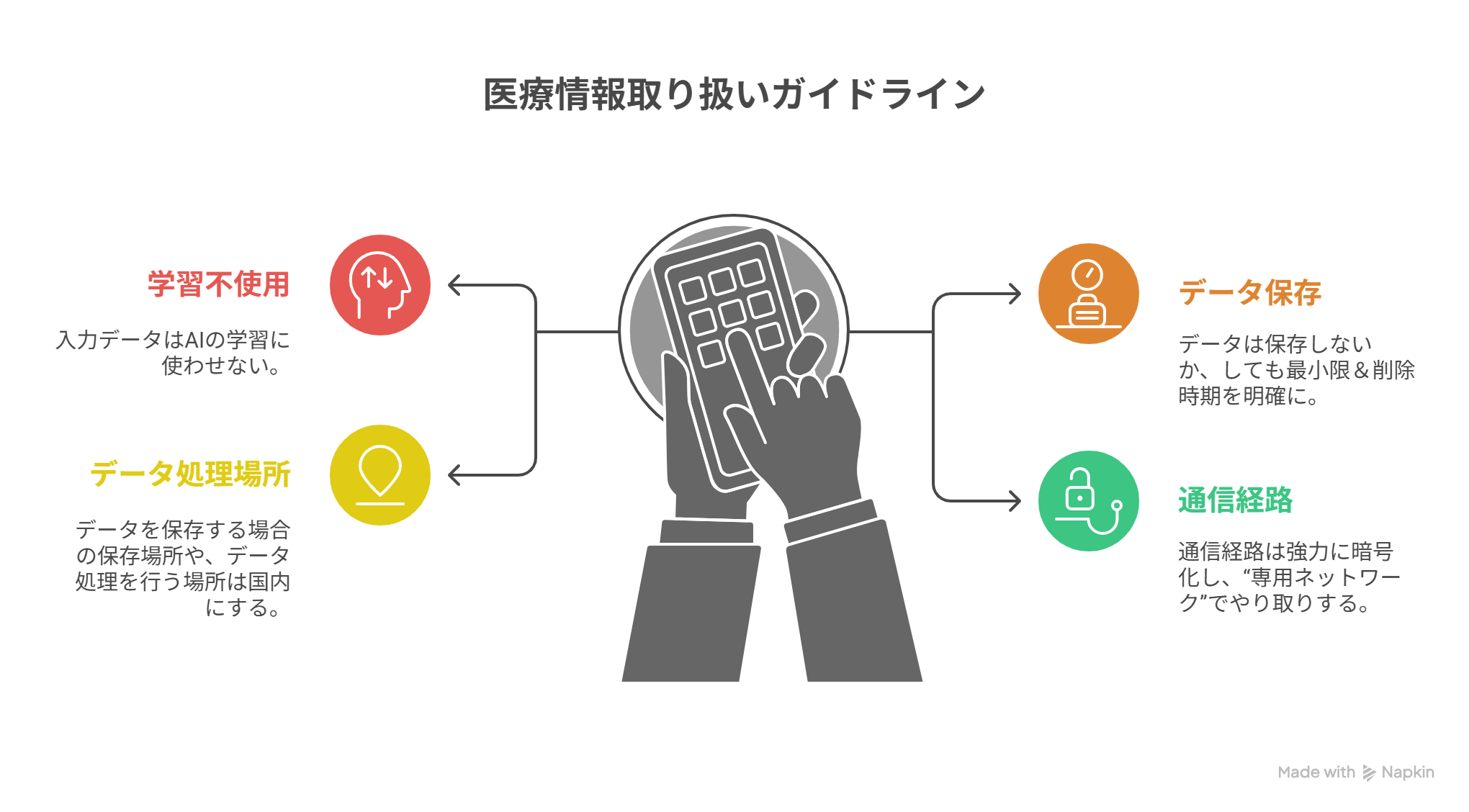

生成AIで医療情報を扱う場合:

・入力データはAIの学習に使わせない(学習不使用)

・データは保存しないか(推奨)、しても最小限&削除時期を明確に

・データを保存する場合の保存場所や、データ処理を行う場所は国内にする(日本の法律で守れる状態に)

・通信経路は強力に暗号化し、“専用ネットワーク”でやり取りする

医療田:

ふんふん、、

"学習させない・保存しない・国内・暗号化と専用ネットワーク"

、ね。

機械屋:

その通りです。

で

「じゃあ、どのAIが使えるのか?」

これが一番気になるところですが、以下に一気に解説しますね。

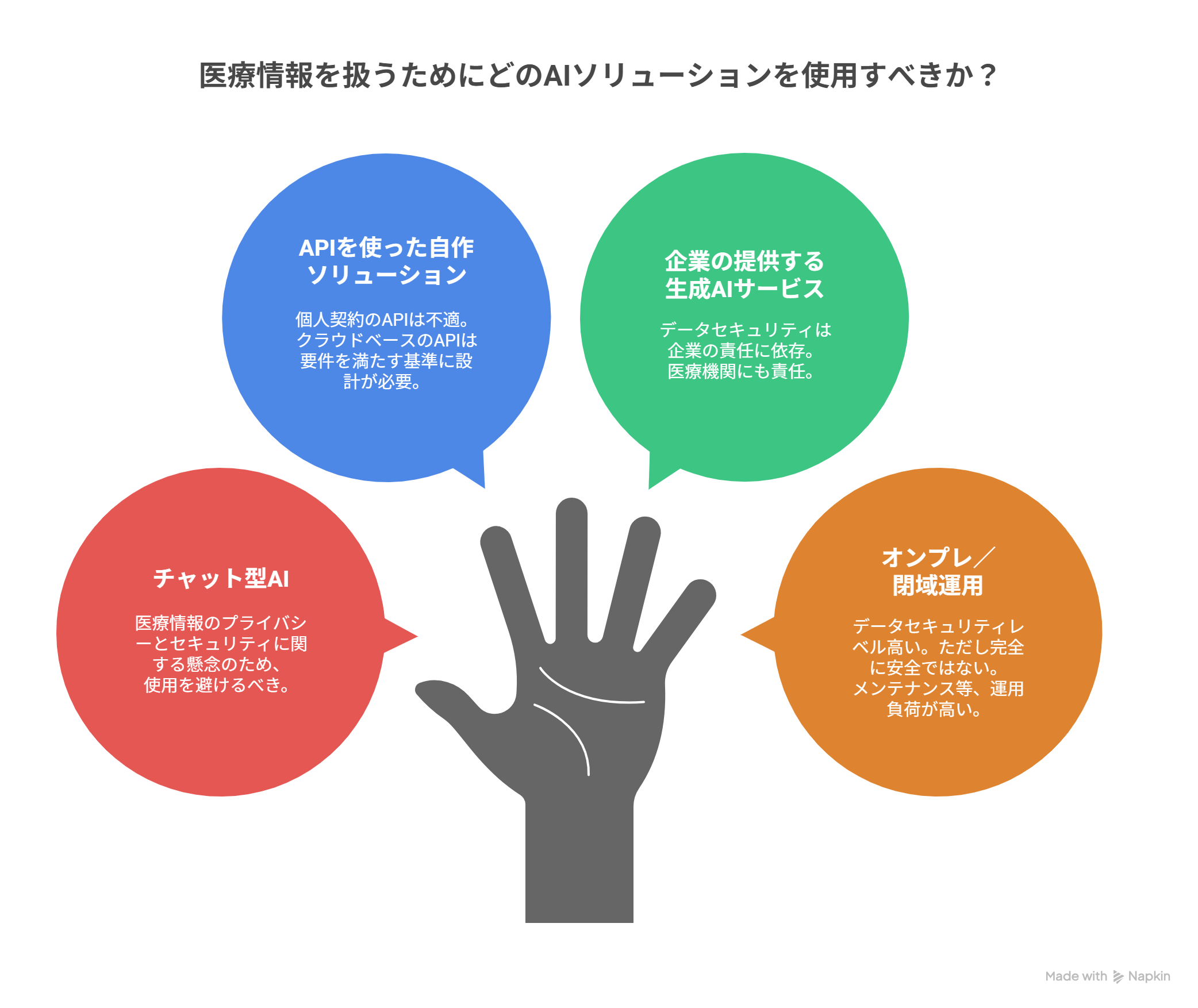

- ChatGPTやClaudeのようなチャット型AI

医療情報はNGですね、学習される可能性がありますし、学習をオフにしていても、データの保存や通信のプライバシーレベルに関して、要求されている水準に合わせるのは難しいです。エンタープライズ契約型のものは例外ですが、これも施設の方針に合わせてください。

- APIを使った自作型

個人契約のAPIは閉域網や契約上のデータ管理要件を満たせないため、実質NGです。

Microsoft Azureや、AWSなどのクラウドが提供する環境とAPIで動作させるタイプであれば、先ほどの基準に合うように構築されているものであれば使用可能です。

- 企業の提供する生成AIサービス

これはMicrosoftのCopilotや、Ubieなど医療に特化したものもそうですが、企業の提供するデータセキュリティに依存しますね。

ここで大事なのは、企業の提供する生成AIサービスを利用するとき、

「医療機関側にも責任が残る」

という点です。

この点は『厚生労働省の「医療情報システム安全管理ガイドライン(第6版)」についてのQ&A』等にも、

『情報漏えい等の情報セキュリティインシデントに際しては、当該情報を一次管理している医療機関等側に、説明責任及び善後策を講ずる責任が発生します』(経1.3章 経Q-6)

と、記載があります。

つまり、

企業に“全部おまかせ”ではなく、医療機関側もデータ管理の主体として責任を負う、ということなんですね。

- オンプレ/閉域運用

データを外に出しませんので、理想的な運用であれば、最も安全です。

ただ、

前回も示したように、メンテナンスやアップデート、トラブルシューティングを自前で行う必要がありますので、運用負荷が大きいのも事実です。

また、

かつてUSBメモリーを介して医療用端末にコンピューターウイルスがはいりこむことが問題になったように、

「閉じているから安全」というわけでは必ずしもない、ということにも注目すべきですね。

● 各ガイドラインの概要

では、以下に各ガイドラインの概要を示します。

ただし、詳細はガイドラインを直接当たっていただくのに越したことはないです。

以下の概要はガイドラインを確認するための足掛かりにしていただければと思います。

1. 厚生労働省の「医療情報システム安全管理ガイドライン(第6版)」についてのQ&A

これは、医療機関が守るべき最低限の“セキュリティ憲法”的な重要なガイドラインです。

2025年7月に、このガイドラインについてのQ&Aが公表されましたが、

その中で 生成AIの取り扱い について明確な言及があります。

そこでは、

「生成AIサービスのプロンプトに医療情報を入力する場合、

・入力された情報が AIの学習目的で保存されない ことが

・契約などで担保されていれば、

サーバが国内法の適用下になくても利用できる」

ということが示されています。

裏返すと、海外製の基盤モデルを使う場合でも、

・保存されない(Zero-Data Retention:ZDR)設定

・学習への利用なし

が契約で保証されていれば利用は可能です。

一方で、現在「国産の基盤モデル」は、どうしても、数が限られる、したがって海外の基盤モデルを使うことになる(海外にデータが出ていく)ので、

医療情報を扱う現場で生成AIを活用する場合、

実質的に“ゼロ保存(ZDR)下での利用”か、

保存を許すのであれば、保存場所・利用目的(学習禁止)・削除方法を契約で細かく保証しておくことが必須です。

医療田:

なるほど。。

機械屋:

それと当然、

院内オンプレミス環境に基盤モデルを導入して使う、も、選択肢に残ります。

2. 医療・ヘルスケア分野における生成AI利用ガイドライン(第2版)

機械屋:

このガイドラインは非営利法人 医療AIプラットフォーム技術研究組合(HAIP)によるもので、

その名の通り、"医療AI"に関するもので、医療現場における生成AIの利活用場面(ユースケース)をまとめたうえで、

これにかかわるリスクや注意事項を、さまざまな観点から整理しています。

ここで紹介されているユースケースには、

・カルテ作成や予約入力などの事務作業を軽くする 「ドキュメントワーク支援」

・病状説明をわかりやすくしたり、説明文を整える 「コミュニケーション支援」

・生活習慣改善メッセージなどの 「フォローアップ支援」

などが挙げられています。

医療田:

なるほど!

生成AI、「いろいろ使えそう」と思ってたけど、こうやって整理されるとわかりやすいね!

機械屋:

そうですね。

で、"生成AI利用者"という立場からの データセキュリティの観点では、「個人」と「組織」として、ガイドラインに次のように書かれています。

まず、個人としての医療従事者が守るべきポイントですが、

「自分の所属組織が利用を許可したAIだけを使う」ことが絶対条件です。

そのうえで、組織が許可する生成AIは、

・入力が“AIの再学習に使われない”設定になっているか?

・サーバの設置場所が適切か?(国内 または契約によって国内法の保護を受ける形)

・入力データを保存する場合、国内法の適用を受ける場所で保存されるか?

・TLS1.3+クライアント認証などの安全な通信方式か?

などが守られている必要がある、としています。

また、組織(医療機関)としては以下の通りのポイントが示されています。

・組織として利用可能な生成AIサービスのリストを選定、職員に通知

・生成AIの利用ルールを整備し、職員に守らせる

・組織としての生成AI利用状況も把握

・適切にAIを運用できるよう研修を実施

などです。

医療田:

医療施設の、“職員”と“組織”、ね。

機械屋:

そうです。

さらに、"自分の組織で使う生成AIを自前で開発する場合”には、

本ガイドラインの第3章「生成AIの開発者が特に注意すべきポイント」

も、確認する必要があります。大まかな内容としては:

① 不適切利用が起きないような仕組みづくり

② 正確性・信頼性の確保

③ 著作権への配慮

④ 個人情報保護

⑤ OSS基盤モデル利用の場合は、学習データを安全に管理し、モデルの改ざんや不正アクセス対策を実施

⑥ 医療判断に使う場合は“医療機器”扱いになる可能性、薬事承認が必要になることがあることに注意

などです。

医療田:

なるほどー。。

機械屋:

というわけで、医療田さんも、もしご自身で開発してみるなら、

この第3章、しっかり把握しておく必要がありますよ?

医療田:

ですよねー…。あとでちゃんと読んでおきます!

3. ヘルスケア領域において生成AIを活用したサービスを提供する事業者が参照するための自主ガイドライン (ヘルスケア生成AI活用ガイド) 第2.0版

機械屋:

このガイドラインは、タイトルにもあるように、病院よりも、ヘルスケア系アプリやWebサービスを作っている事業者側を対象とした内容ですね。

サービスに使われるAIを開発する段階でのデータの取り扱いについてのチェックポイントが示されていますし、サービス提供時には利用者がプライバシーポリシーを理解しやすいように設計する、いわゆる"プライバシー・バイ・デザイン"を求める内容にもなっています。

事業者側には、例えば以下が求められます。

・入力されたデータが勝手に再学習に使われないこと

・個人情報(特に要配慮情報)が“即時削除・匿名化”される設計であること

・機密情報や著作権情報が入力された場合の扱いを明確にしておくこと

つまり、ヘルスケアサービスを“作る側”に対して、かなり細かいデータ取扱いルールを示している点が特徴です。

その意味では、先に挙げた、医療機関向けのガイドライン(厚労省ガイドラインやHAIP)の方が、医療現場の実務に直結した情報はより詳しいと言えます。

医療田:

へー。

あ、でも、自分でアプリ作ってみようかな、と思っている私には、よく読んでおいたほうがよさそうだね。

機械屋:

おっしゃる通りですね。

このガイドラインには具体的なチェックリストも用意してあるので、その際には活用されるとよいかと思いますよ。

4. AI事業者ガイドライン(第1.1版)

機械屋:

この“AI事業者ガイドライン”は、実はこれまでバラバラに存在していた複数のAI関連ガイドライン

・AI開発ガイドライン(AIをつくる企業向け)

・AI利活用ガイドライン(AIを使う立場向け)

・AI原則実践のためのガバナンス・ガイドライン(企業のAI運用体制づくり向け)

を統合し直し、整理した最新版で、欧米での議論なども踏まえてアップデートされています。

AI開発者、AI提供者、そしてAI利用者と、異なる立場ごとへのガイダンスをそれぞれ行っているのが特徴ですね。

このなかで、今回重要なのは「AI利用者」の章だと思いますが、

その内容を一言でいうと

「AI利用者は、提供者が想定した範囲で使い、個人情報や機密情報を不用意に入力してはいけない」というものになりますし、特に

「生成AIに入力する個人情報・機密情報は、学習に使われる設定なら入れてはならない」

ことが明記されています。

医療田:

ふーん。

機械屋:

データセキュリティについての具体的な考え方は、先ほどの”「医療情報システム安全管理ガイドライン(第6版)」についてのQ&A”に、譲る形ではありますね。

======

● 関連記事

2分で読める生成AIのいま Vol.28「データセキュリティから見る生成AIのタイプ」

https://www.youichimachida-ai.com/blog/2ai-vol28ai

● 2分で読める「生成AIのいま」シリーズ。バックナンバーはブログからどうぞ!

https://www.youichimachida-ai.com/blog